引言

在信息爆炸的时代,数据已经成为企业、科研机构和政府决策的重要依据。然而,随着网络信息的不断更新,如何快速、准确地获取最新数据成为了一个亟待解决的问题。自动实时更新的数据爬虫应运而生,它能够自动地从互联网上抓取数据,并实时更新,为用户提供及时、准确的信息服务。

数据爬虫的基本原理

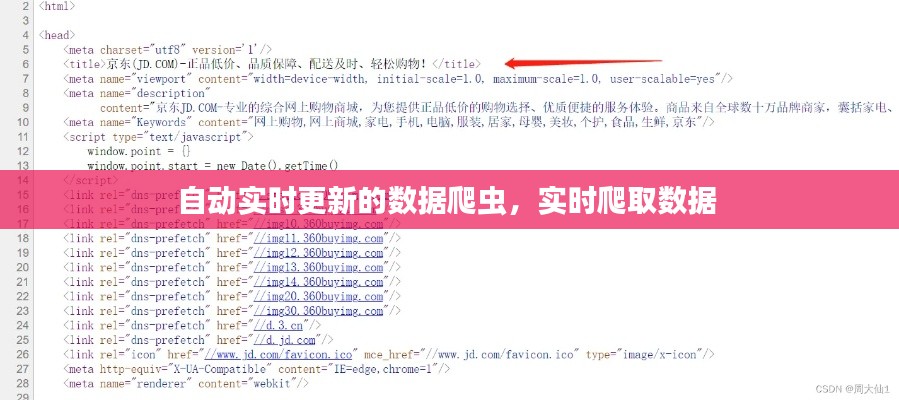

数据爬虫,也称为网络爬虫,是一种自动化程序,用于从互联网上抓取数据。它通过模拟浏览器行为,访问网站,解析网页内容,提取所需信息,并将其存储到数据库中。数据爬虫的基本原理包括以下几个步骤:

- 爬取目标网站:确定需要爬取数据的网站,并获取网站的URL。

- 网页解析:使用解析库(如BeautifulSoup、lxml等)解析网页内容,提取所需数据。

- 数据存储:将提取的数据存储到数据库中,以便后续处理和分析。

- 数据更新:定期检查数据源,发现新数据后进行更新。

自动实时更新的关键技术

自动实时更新的数据爬虫需要具备以下关键技术,以确保数据的及时性和准确性:

- 定时任务调度:通过定时任务调度器(如cron、Windows Task Scheduler等)定期执行爬虫程序,实现数据的定时更新。

- 增量爬取:只爬取新数据或更新后的数据,避免重复抓取和浪费资源。

- 数据去重:对抓取到的数据进行去重处理,确保数据的唯一性和准确性。

- 异常处理:在爬取过程中,可能会遇到各种异常情况,如网络中断、服务器拒绝访问等,需要具备良好的异常处理能力。

- 分布式爬取:对于大量数据或大型网站,可以采用分布式爬取技术,提高爬取效率和稳定性。

自动实时更新的数据爬虫应用场景

自动实时更新的数据爬虫在各个领域都有广泛的应用,以下是一些典型的应用场景:

- 舆情监测:通过爬取社交媒体、新闻网站等平台的数据,实时监测网络舆情,为企业或政府提供决策支持。

- 市场调研:爬取电商平台、行业报告等数据,分析市场趋势,为企业提供市场调研服务。

- 金融风控:爬取股票、期货、外汇等金融市场数据,实时监控市场动态,为金融机构提供风险控制服务。

- 学术研究:爬取学术论文、专利、研究报告等数据,为科研人员提供学术资源。

自动实时更新的数据爬虫面临的挑战

尽管自动实时更新的数据爬虫具有广泛的应用前景,但在实际应用过程中也面临着一些挑战:

- 法律风险:爬取数据可能涉及版权、隐私等问题,需要遵守相关法律法规。

- 技术挑战:爬取大型网站或动态网页时,需要解决反爬虫技术、数据解析等技术难题。

- 数据质量:爬取到的数据可能存在不准确、不完整等问题,需要经过清洗和验证。

- 资源消耗:爬取大量数据需要消耗大量计算资源,对服务器性能提出较高要求。

结论

自动实时更新的数据爬虫在信息时代具有重要的应用价值。通过不断优化技术,提高数据爬取的效率和准确性,数据爬虫将为各行各业提供更加便捷、高效的数据服务。同时,我们也应关注数据爬取过程中的法律、技术、数据质量等问题,确保数据爬取的合规性和可持续性。

转载请注明来自西北安平膜结构有限公司,本文标题:《自动实时更新的数据爬虫,实时爬取数据 》

百度分享代码,如果开启HTTPS请参考李洋个人博客

鲁ICP备16008434号-2

鲁ICP备16008434号-2