引言

随着大数据时代的到来,实时数据处理和分析已经成为企业竞争的关键。Flink作为一款高性能的流处理框架,因其低延迟、高吞吐量和容错性等特点,在实时数仓领域得到了广泛应用。本文将介绍Flink在实时数仓实践中的应用,包括架构设计、数据处理流程和性能优化等方面。

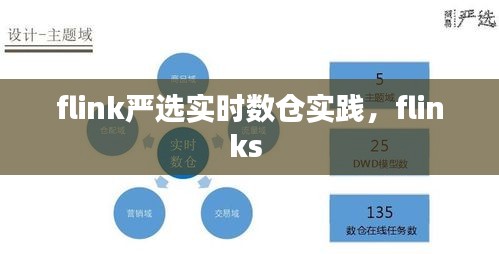

架构设计

在Flink严选实时数仓实践中,我们采用了以下架构设计:

数据源:包括日志数据、业务数据等,通过Kafka等消息队列进行数据收集。

数据存储:使用HDFS或分布式数据库(如HBase)作为数据存储,保证数据的持久化和高可用性。

数据处理:Flink作为流处理引擎,负责对实时数据进行处理和分析。

数据展示:通过BI工具(如Tableau、Power BI)将处理后的数据可视化展示给用户。

数据处理流程

Flink严选实时数仓的数据处理流程如下:

数据采集:通过Kafka等消息队列,将实时数据源源不断地传输到Flink集群。

数据清洗:在Flink中,对采集到的数据进行清洗,包括去除重复数据、处理缺失值、转换数据格式等。

数据转换:根据业务需求,对清洗后的数据进行转换,如计算指标、聚合数据等。

数据存储:将处理后的数据存储到HDFS或分布式数据库中,以便后续查询和分析。

数据展示:通过BI工具将数据可视化展示给用户,帮助用户快速了解业务状况。

性能优化

为了保证Flink严选实时数仓的性能,我们采取了以下优化措施:

并行度优化:根据数据量和集群资源,合理设置Flink的并行度,提高数据处理效率。

状态后端优化:使用RocksDB作为状态后端,提高状态存储和恢复性能。

内存管理优化:合理配置Flink的内存资源,避免内存溢出和资源浪费。

网络优化:优化网络配置,降低网络延迟和丢包率。

负载均衡优化:合理分配任务到各个节点,提高集群利用率。

案例分析

以下是一个Flink严选实时数仓的实际案例:

某电商平台希望通过实时数仓了解用户购买行为,从而进行精准营销。我们使用Flink对用户购买日志进行实时处理,包括以下步骤:

数据采集:通过Kafka采集用户购买日志。

数据清洗:去除重复数据、处理缺失值、转换数据格式等。

数据转换:计算用户购买频率、购买金额等指标。

数据存储:将处理后的数据存储到HDFS中。

数据展示:通过BI工具将数据可视化展示,为营销团队提供决策支持。

通过Flink严选实时数仓,电商平台能够实时了解用户购买行为,及时调整营销策略,提高用户满意度和销售额。

总结

Flink在实时数仓领域的应用具有显著优势,能够帮助企业实现实时数据处理和分析。通过合理的架构设计、数据处理流程和性能优化,Flink严选实时数仓能够为企业带来巨大的价值。本文介绍了Flink在实时数仓实践中的应用,希望对相关从业人员有所帮助。

转载请注明来自西北安平膜结构有限公司,本文标题:《flink严选实时数仓实践,flinks 》

鲁ICP备16008434号-2

鲁ICP备16008434号-2