引言

随着大数据时代的到来,实时数据处理和分析变得越来越重要。在众多实时计算框架中,Apache Flink因其强大的流处理能力和高吞吐量而备受关注。本文将探讨如何使用Flink进行实时计算,并生成统计报表,以满足现代业务对实时数据洞察的需求。

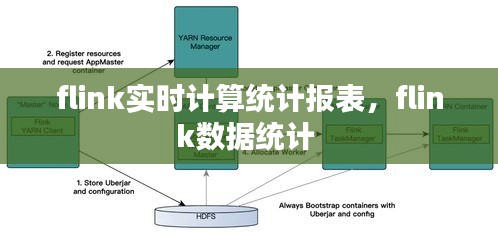

什么是Apache Flink

Apache Flink是一个开源的流处理框架,旨在提供在所有常见集群环境中高吞吐量和低延迟的流处理。它支持事件驱动架构,能够处理有界和无界的数据流,并能够进行复杂的事件处理和分析。Flink广泛应用于实时分析、机器学习、复杂事件处理等领域。

Flink实时计算的基本原理

Flink的实时计算基于事件驱动模型,通过处理事件流来生成实时结果。以下是Flink实时计算的基本原理:

事件时间(Event Time):Flink支持事件时间,这意味着处理结果基于事件实际发生的时间。

处理时间(Processing Time):如果需要,Flink也可以使用处理时间,即事件被处理的时间。

窗口(Windows):Flink提供了多种窗口类型,如滚动窗口、滑动窗口、会话窗口等,用于对事件进行分组和聚合。

状态(State):Flink支持持久化状态,这意味着即使在系统故障后也能恢复计算状态。

使用Flink生成统计报表

使用Flink生成统计报表通常涉及以下步骤:

数据源:首先需要确定数据源,可以是消息队列、数据库、文件系统等。

数据读取:使用Flink提供的连接器(如Kafka、RabbitMQ、JMS等)读取数据源中的数据。

数据转换:对读取到的数据进行转换,如过滤、映射、连接等。

窗口操作:根据业务需求,对数据进行窗口操作,如按时间窗口或计数窗口进行聚合。

统计计算:在窗口内进行统计计算,如求和、平均值、最大值、最小值等。

结果输出:将计算结果输出到目标系统,如数据库、HDFS、仪表盘等。

案例:实时用户行为分析

以下是一个使用Flink进行实时用户行为分析的示例:

数据源:假设我们有一个用户行为日志,记录了用户在网站上的点击事件。

数据读取:使用Flink Kafka连接器读取Kafka中的用户行为日志。

数据转换:将日志中的数据转换为事件流,包括用户ID、事件类型、事件时间等。

窗口操作:对事件流进行时间窗口操作,将相同时间窗口内的点击事件进行聚合。

统计计算:计算每个时间窗口内的点击次数、平均点击时间等统计指标。

结果输出:将统计结果输出到数据库或实时仪表盘,以便实时监控用户行为。

总结

Apache Flink是一个功能强大的实时计算框架,能够帮助企业和组织快速构建实时数据处理和分析系统。通过使用Flink,可以轻松生成各种统计报表,为业务决策提供实时数据支持。随着技术的不断发展和应用场景的拓展,Flink在实时计算领域的应用前景将更加广阔。

转载请注明来自西北安平膜结构有限公司,本文标题:《flink实时计算统计报表,flink数据统计 》

鲁ICP备16008434号-2

鲁ICP备16008434号-2